[자율규제의 미래] 인공지능(AI)과 자율규제

1. 인공지능의 영향력 확대

1956년 미국 다트머스 대학에서 열린 이른바 ‘다트머스 회의(Dartmouth Conference)’는 인공지능의 역사를 짚어볼 때 자주 등장한다. 존 매카시(John Mccarthy)와 마빈 민스키(Marvin Minsky) 등 여러 학자가 공동으로 제안한 이 컨퍼런스는 인공지능(Artificial Intelligence) 연구의 시작과 용어를 탄생시켰다. 존 매카시가 인공지능이라는 단어를 처음 쓰기 시작했고, 마빈 민스키는 인공지능을 “기계가 사람처럼 지능이 필요한 일을 하도록 만드는 과학”이라고 정의했다.

“기계가 사람처럼 생각하게 된다고?!” 그렇다. 당시만 하더라도 인공지능이란 것이 학문적 연구의 가능성 또는 영화 속에서나 일어날 수 있는 일이라고 여길 뿐 누구나 체감할 수 있는 우리 삶의 가까운 기술은 아니었다. 하지만 약 66여년이 지난 지금 우리는 당시 유능한 과학자들이 발견한 다듬어지지 않은 원석이 곧 세상을 바꿀 무한의 가능성을 지닌 보석임을 인정하고 있다. 다시 말해 인공지능이라는 기술이 가진 가능성과 가치를 느낄 수 있는 시대를 살아가고 있는 것이다.

모든 기술이 그러하듯 특정 기술의 발달은 우리도 모르는 사이, 우리에게 가까이 자리 잡는다. 스마트폰이 세상에 나오기 전에 우리는 길을 찾기 위해 종이 지도를 봐야 했고, 누군가에게 연락하기 위해 공중전화의 긴 줄을 서는 불편을 감수했었다. 그런데 지금 이런 이야기를 하면 디지털 시대에 나고 자란 디지털 네이티브(Digital Native) 세대들은 그런 과거를 상상하기 어려울 것이다. 기술의 발전 속도는 더욱 빨라졌다. 아직은 일반인들이 느끼는 인공지능이란 것이 맞춤형 정보를 제공 받고, 얼굴을 인식하고, 자율주행이 가능한 정도지만 머지않아 기술이 점차 진화하여 공상과학 영화 속 일들이 현실이 된다면, 우리가 살고 있는 오늘이 누군가에게는 상상도 못 할 진부한 과거가 될 수도 있다.

최근 국내외 주요 정부, 기업, 단체들은 인공지능이 가져올 기회와 위협에 민첩하게 대응하고자 분주하다. 인간과 닮은, 인간의 지능을 능가할 수도 있을 넥스트 인공지능 시대를 준비하기 위해 기술개발과 함께 책임과 윤리적 문제도 고려하고 있는 것이다. 인공지능 기술이 주는 기회와 위기 즉, 기술의 양면성이 우리 사회에 던지는 도전과제를 어떻게 풀어나가야 할지 본격적으로 준비해야 할 때이다.

2. 인공지능(AI)과 자율규제

최근 인공지능을 활용한 다양한 서비스가 등장하면서 인공지능 기술의 중요한 자원인 데이터 및 알고리즘의 수집-학습-개발-활용 단계에서 다양한 역기능이 발생하고 있다. 주로 편향된 데이터 및 알고리즘의 활용, 개인정보의 비식별화 조치 미흡 등 편견과 차별, 경제 사회적 불평등, 인권침해, 범죄 악용 등의 문제를 야기하고 있다.

2015년 ‘구글 포토’에 아프리카계 미국인 재키 앨신이 자신의 흑인 여성 친구 사진을 찍어 올리자 인공지능이 자동으로 ‘고릴라’라고 분류하고 사진에 태그를 붙여 논란이 되었고, 아마존의 경우 그간의 자사 고용패턴을 학습시킨 AI 채용시스템을 2018년 폐기했다. 남성 지원자가 많았던 과거 데이터를 학습한 시스템이 여성 지원자의 평가점수를 감점하는 결과를 가져왔기 때문이다. 우리나라에서는 2020년 스타트업 스캐터랩이 서비스한 인공지능 챗봇 ‘이루다’의 혐오와 차별 메시지 전송, 개인정보 침해 등이 논란이 되면서 인공지능의 역기능에 대한 우려와 관심을 촉발했다.

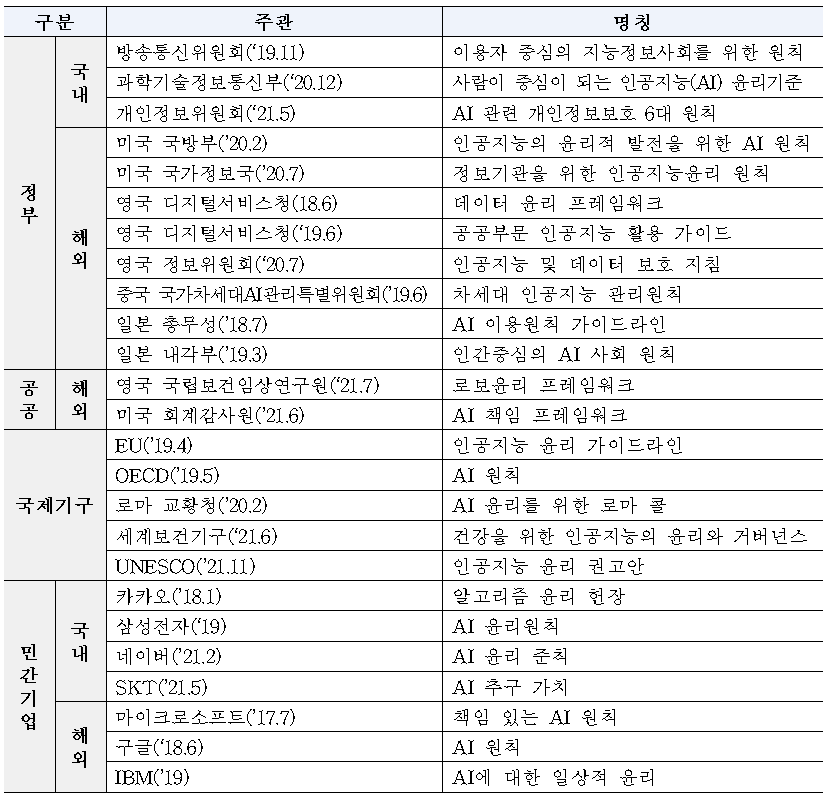

우리나라를 포함해 해외 주요국과 기업은 자율규제 활동의 일환으로 인공지능 편향성의 사회적 파급과 차별 확산에 대비한 개발자, 이용자, 공급자가 지켜야 할 기본 원칙을 앞 다퉈 발표했다. 주로 정부는 국가 AI 전략의 일부로, 민간은 내부 관리 및 통제를 위해, 국제기구 등은 공통의 AI 윤리 이니셔티브 확보 차원으로 접근한 것을 알 수 있다.

하버드 법대 버크만 클라인 센터는 2016부터 2019년에 발표된 AI 윤리 원칙 중 36건을 분석(OECD, EU, 구글, 텐센트 등) 하여, ① 개인정보보호, ② 책무성, ③ 안전과 보안, ④ 투명성과 설명 가능성, ⑤ 공정성과 비차별성, ⑥ 기술 통제성, ⑦ 전문가 및 이해관계자 책임, ⑧ 인적 가치 증진이라는 8가지의 공통 가치를 제시했다.

앞서 표에 제시한 최근의 국내외 주요 가이드 및 원칙을 버크만 클라인 센터의 8가지 가치에 대입해 보면 인공지능 윤리기준에서 공통적으로 포함하고 있는 가치는 공정성과 비차별성, 투명성과 설명 가능성, 안전과 보안, 개인정보보호, 책무성, 인적가치 증진이 높은 순으로 나타났다. 참고로 공란이 있다고 해서 각 기관의 윤리기준에 해당 가치를 전혀 담고 있지 않다는 것이 아니며, 가장 강조한 부분을 중심으로 분석하였음을 밝힌다.

인공지능 윤리 원칙, 권고안, 가이드, 헌장이라는 것이 법의 테두리 안에서 구속력을 갖는 것은 아니지만 국내외 정부, 민간, 단체들의 이런 행보는 인공지능 역기능에 대응하기 위한 방법 중 하나로 자율규제가 대안이 될 수 있다는 것을 보여주는 사례이다.

3. 인간을 위한 인공지능 시대를 맞이할 준비

그동안은 주로 정부 주도의 사전규제 중심으로 역기능을 해소하고자 했다. 하지만 지금과 같이 급속한 기술의 발전 속도를 법과 제도가 따라가기에는 한계가 있다. 하나의 법이 마련되기까지 시간은 짧게는 수개월, 길게는 몇 년이 걸리기도 하니 말이다. 또 법이 마련되었다 하더라도 새롭게 등장하는 혁신적인 기술과 서비스는 기존의 법제도 체제와 충돌하거나, 공백이 발생할 수밖에 없다.

앞서 살펴본 것과 같이 주요국 정부와 기업이 인공지능을 개발·공급·활용하고자 할 때 지켜야 하는 일정한 규범을 제시하는 것은 인공지능에 대한 자율적인 책임 노력이 확산되고 있다는 것을 보여준다. 이처럼 법에서는 최소한의 규정을 명시하고, 나머지 세세한 부분은 자율규제 또는 모두가 공유하는 규범에 맡기는 것 즉, 법제도와 함께하는 사회적 합의의 전제가 기술과 역기능의 발전 속도를 따라가는 해법일 것이다.

무엇보다 책임이 없는 자율은 없다. 원칙을 세우는 것만큼 책임을 갖고 실행하는 것도 중요하다. 일회성 발표에서 그치는 것이 아닌 실제 인공지능 기술개발 과정에서의 윤리 원칙 준수 여부를 감독하고, 알고리즘이 특정 인종, 성별, 정치 등에 편향되지 않도록 다양성과 포용성을 확보하는 실천적 노력이 함께 해야 한다. 수립한 원칙에 의거하여 구성원 개개인이 책임 있게 기술을 개발하고, 서비스를 제공할 때 역기능으로부터 이용자를 안전하게 보호할 수 있다.

발생가능한 문제를 사전에 방지하기 위해서 최소한의 법 제도적 장치는 꼭 필요하다. 다만, 하루가 다르게 급진전하는 지능정보사회에서 법과 제도로만 인공지능 역기능 문제를 해결하는 것은 쉽지 않다. 우리나라가 글로벌 인공지능 기술 경쟁력을 갖추기 위한 유연성과 민첩성, 기술 활용의 결과에 대한 공정성과 비차별성, 정부와 민간의 협력과 조정, 그리고 서로의 성공과 실패 경험을 공유하고 국민의 안전을 최우선시하고자 하는 변화와 학습이 우선되어야만 인공지능의 가치를 극대화하고 역기능을 최소화할 수 있다.

[참고문헌]

1. 개인정보위원회(2021). AI 관련 개인정보보호 6대 원칙.

2. 과학기술정보통신부(2020). 사람이 중심이 되는 인공지능(AI) 윤리기준.

3. 방송통신위원회(2019). 이용자 중심의 지능정보사회를 위한 원칙.

4. 삼성전자(2019). AI 윤리원칙. https://www.samsung.com

5. 네이버(2021). AI 윤리 준칙. www.navercorp.com

6. kakao(2018). 알고리즘 윤리 헌장. www.kakaocorp.com

7. SK텔레콤(2021). AI 추구 가치. www.sktelecom.com

8. 総務省(2018). AI 利活用ガイドライン.

9. 内閣府(2019). Social Principles of Human-Centric AI. https://www.cas.go.jp/

10. 发科學技術部(2019). 展负责任的人工智能:新一代人工智能治理原则发布. https://www.most.gov.cn/

11. Berkman Klein Center(2020). Principled Artificial Intelligence.

12. DCMS(2021). Government Response to the Committee on Standards in Public Life’s 2020 Report. AI and Public Standards.

13. DOD(2020). DOD Adopts Ethical Principles for Artificial Intelligence. https://www.defense.gov/

14. EU(2019). ETHICS GUIDELINES FOR TRUSTWORTHY AI.

15. GAO(2021). Artificial Intelligence: An Accountability Framework for Federal Agencies and Other Entities.

16. Google(2018). Artificial Intelligence at Google: Our Principles. https://ai.google/principles

17. Government Digital Service(2018). Data Ethics Framework.

18. Government Digital Service(2019). A guide to using artificial intelligence in the public sector.

19. IBM(2019). IBM’s Principles for Trust and Transparency. www.ibm.com

20. Information Commissioner’s Office(2020). Guidance on AI and data protection.

21. Microsoft(2017). Empowering impactful responsible AI practices. www.microsoft.com

22. NICE(2021). Robo-Ethical Framework.

23. OECD(2019). Recommendation of the Council on Artificial Intelligence.

24. Pontifical Academy for Life(2020). Rome Call for AI Ethics.

25. UNESCO(2021). Recommendation on the Ethics of Artificial Intelligence.

26. United States Intelligence Community(2020). Principles of Artificial Intelligence Ethics for the Intelligence Community.

27. WHO(2021). ETHICS AND GOVERNANCE OF ARTIFICIAL INTELLIGENCE FOR HEALTH.

이전 글

이전 글  다음 글

다음 글  글로벌 IP 산업의 중심이 된 한국 웹툰

글로벌 IP 산업의 중심이 된 한국 웹툰 ![[회원사가 바라본 KISO] ①심심이 최정회 대표](https://journal.kiso.or.kr/wp-content/uploads/2022/11/KDR51388-620x350.jpg) [회원사가 바라본 KISO] ①심심이 최정회 대표

[회원사가 바라본 KISO] ①심심이 최정회 대표  해외 인터넷 자율규제의 변화와 한국 자율규제의 미래

해외 인터넷 자율규제의 변화와 한국 자율규제의 미래  최근 개인정보 대량 유출 사태를 둘러싼 쟁점 및 동향

최근 개인정보 대량 유출 사태를 둘러싼 쟁점 및 동향  <기획특집 ③> 소비자 리뷰 게시물 관련 정책 추진의 실현 가능성 및 한계

<기획특집 ③> 소비자 리뷰 게시물 관련 정책 추진의 실현 가능성 및 한계  자기게시물 접근배제요청권 가이드라인에 관한 일고찰

자기게시물 접근배제요청권 가이드라인에 관한 일고찰  사물인터넷 활성화를 위한 법적 과제

사물인터넷 활성화를 위한 법적 과제  연관검색어 및 자동완성 검색어 서비스의 작동 원리와 제공 방식

연관검색어 및 자동완성 검색어 서비스의 작동 원리와 제공 방식