인공지능을 둘러싼 법의 관심과 그 지향점에 관한 일고(一考) – 미국의 인공지능과 법에 관한 논의 동향을 중심으로

인공지능에 대한 기대와 관심이 날로 고조되고 있다. 세간에서 논의되는 인공지능의 개념은, 인간 수준의 지능을 모사할 수 있는 기계 기반의 지능을 만들어내려는 공학적 활동을 의미하는 것으로 이해된다. 19세기 “컴퓨터의 아버지”라 불리는 찰스 배비지가 계산을 기계화하는 방법을 개발한 것을 계기로 그 가능성이 논의되기 시작하여, 20세기 앨런 튜링을 비롯한 천재적인 수학자들이 계산이론의 기초를 세우면서 보다 구체화된 인공지능 연구가 1955년 이래로 낙관적 전망과 실망을 반복하며 지속되어 왔다는 사실은 익히 알려진 바와 같다. 1990년대 등장한 MRI, CT, PET 등과 같은 뇌 스캔 기술은 최근 비약적으로 발전한 ICT 기술, 컴퓨팅 기술, 데이터 저장 및 처리 기술, 심층 학습(deep learning), 기계 학습(machine learning) 기술과 상승작용을 일으키며 사그라진 인공지능의 불씨에 다시 한 번 희망의 바람을 불어넣었다. 그리고 2014년 6월 한 인공지능 대회에서 대화형 인공지능 로봇인 채터봇(chatterbot)이 튜링 테스트를 통과했다는 발표에 이어 2016년 봄, 구글의 알파고와 이세돌의 바둑대국의 결과는 인공지능의 위력과 실용화의 가능성을 전 세계적으로 확인시키는 계기를 마련하였다.

이와 같은 기술적 진전에도 불구하고 미국 정부는 최근까지 인공지능에 대한 실정법적 관심을 크게 기울이지 않았다. 사회적으로도 엘론 머스크, 스티브 호킹, 빌 게이츠와 같은 거물급 인사들이 제기한 강한 인공지능(예를 들어 공상과학영화에 등장하는 로봇과 같은)이 인류의 실존에 위협을 가할 수 있다는 우려에 관심이 쏠리는 형국이다. 그리하여 일각에서는 실현가능성이 없는 또는 적어도 가까운 장래에 실현되기 어려운 인류 생존의 문제(existential risk)에 대한 과도한 관심이 약한 인공지능(구글의 알파고, IBM의 왓슨, 애플의 시리 등)이 우리 사회에 제기하는 실질적인 이슈들에 대한 법적‧정책적 논의를 방해한다는 지적도 제기된다. 실제로 2016년 상반기를 기준으로 미국에서는 아직 강약을 불문하고 인공지능 일반을 직접 다루거나 규율하는 법률이나 입법안은 존재하지 않는다. 다만, 드론, 자율주행자동차, 의료 소프트웨어(예를 들어 암 진단분석시스템) 등 약한 인공지능을 이용한 특정 장치나 기기에 관한 규제입법이 이루어졌거나 검토되고 있을 뿐이다. 물론 현행 전자상거래법이나 기술 중립적인 저작권법, 데이터에 관한 법률 등이 인공지능에 적용될 수 있다. 인공지능 규제정책이나 법제 마련 등에 대한 미국 정부의 소극적 태도는 최근 법률, 공학, 철학 전문가로 구성된 컨소시엄의 로봇법(RoboLaw) 프로젝트 결과보고서(D6.2 Guidelines on Regulating Robotics)를 검토한 유럽연합의 정책입안자들과 상당한 온도차를 보인다. 이 보고서에는 로봇 및 인간의 역량을 강화하는 신기술의 사회적 도입을 관리하는 방법에 관한 권고사항이 포함되어 있는데, 그와 같은 결론을 도출하기 위해서 해당 연구진은 로봇공학에 대한 규제, 윤리의 역할, 법적 책임소재, 로봇에 대한 법인격 부여 문제 등 다양한 이슈들을 심도 있게 검토하였다. 앞으로 유럽연합은 이 보고서의 내용을 바탕으로 법제 마련 등 후속 조치를 추진할 예정이다.

한편, 미국에서는 산업, 학계 등 민간의 인공지능 전문가들을 중심으로 현재 편만하게 적용되고 있는 약한 인공지능 기술이 사회에 미치는 영향을 이해하는 것이 강한 인공지능의 위험성을 우려하는 것보다 더욱 중요하다는데 공감대가 형성되어 있다. 인공지능 연구개발이 법적 공백 상태에서 이루어지고 있다는 점을 인식한 이들은 정부와 의회를 향해 현존하는 약한 인공지능 기술에 관한 규제체계의 정립, 데이터 규제(특히, 기업의 데이터 수집, 처리 및 이용행위 규제), 사고발생시 책임소재, 인공지능 전체에 대한 규제 패러다임 형성 등의 도전적 과제를, 미래에 이 기술이 빠르게 확장될 수 있다는 사실을 고려하여, 조속히 다루어야 한다고 권고한다. 또한 이들은 인공지능 기술의 이용방식에 관해 공론화를 추진하여 사회적 합의를 도출하고, 인공지능 관련 의사결정에 과학자들을 참여시켜야 한다고 주장한다. 그렇다면, 약한 인공지능과 관련하여 미국의 민간 전문가들이 주목하는 시급한 이슈들은 무엇인가. 크게 네 가지로 정리된다. 빅데이터 관리 문제, 프라이버시 보호 문제, 인간의 기계의존성 문제 그리고 일자리 문제. 이미 백악관에서 다루기 시작한 빅데이터 문제는 생략하기로 하고, 여기에서는 나머지 세 가지 이슈가 제기하는 문제점을 간략히 살펴보기로 한다.

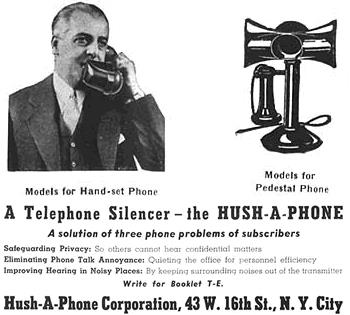

널리 알려진 바와 같이, 현재 인공지능 혁신의 중심에는 심층 학습 기술이 있다. 인간의 뇌의 작동방식에서 영감을 받은 이 기술은 컴퓨터 비전(vision), 대화 인식(speech recognition), 자연어 처리 등에 있어서 상당한 진전을 이끌어 냈다. 이 요소들을 활용하면 검색엔진, 가상지원, 지능형 로봇 등 “개인 맞춤형” 제품과 서비스를 제공할 수 있게 된다. 앞으로 이러한 인공지능 기반기술은 개인의 행위, 감정, 욕구 등을 분석할 수 있는 기능, 즉 프로파일링 기능을 고도화하고 확대해 나갈 것으로 예상된다. 그런데 미국의 전문가들은 바로 이 부분을 우려한다. 이 기술을 사용하는 기업들이 사람의 행위를 예측하는데 더욱 능숙해질 것이고, 예측이 가능한 사람은 쉽게 이용될 수 있기 때문이다. 더욱이 기계 학습 기술은 데이터를 탐색해서 사람의 행위를 “예측”할 수 있을 뿐만 아니라 일정한 수준에서 사람을 “이해”할 수도 있다. 이것이 정부가 프라이버시 보호를 위한 규제에 집중해야 하는 이유이다.

또한 앞으로 사회는 점점 더 인공지능 기술이 탑재된 기계나 시스템에 의존하게 될 것으로 예상된다. 그런데 이러한 기계의존성은 사회적으로 매우 치명적일 수 있다는 데에 많은 이들이 동의하는 분위기이다. 사회 각 분야의 다양한 의사결정이 더욱 더 인공지능에 의존하여 이루어질 것으로 예상되기 때문이다. 그러한 의사결정들은 그 결정을 가능하게 하는 기반기술에 대한 이해 없이 이루어질 가능성이 농후하다. 또한 효율성을 추구하는 사회적 경향은 기계나 시스템에 ‘일반 국민의 삶에 영향을 미치는 결정’을 맡기려는 경향을 강화시킬 것이다. 이미 신용도평가, 대출승인여부, 고용여부, 질병의 판별 및 치료방식, 입국허가여부 등 개인의 삶에 중요한 결정들이 인공지능에 기대어 이루어지기 시작했다.

마지막으로, 인공지능에 의한 자동화, 세계화로 인해 이미 다수의 미숙련 노동자들의 일자리가 대체되었으며, 변호사, 의사와 같은 전문 직역도 그 영향권의 범위에 포함되었다는 점은 주지의 사실이다. 유럽연합의 로봇법 프로젝트 코디네이터였던 에리카 팔메리니 교수는 일자리 문제가 로봇시장 발전에 가장 큰 장애물이 될 것이라고 예상한 바 있다. 자동화의 가속화로 인해 2050년에 이르면 전 세계 인구의 반 또는 그 이상이 일자리를 잃게 될 수 있다는 관측도 있다.

상기의 이유로 미국의 인공지능 전문가들은 정부가 인공지능에 의해 변화된 일반 시민의 삶과 이러한 변화를 다루기 위한 입법의 필요성에 관심을 가져야 한다고 지속적으로 주장하여 왔지만, 미행정부나 연방의회는 인공지능에 대하여 최근까지 이렇다 할 입장을 표명하지 않았다. 그리하여 실리콘 밸리의 주요 기업들과 인공지능 관련 기업들이 자발적으로 인공지능에 대한 법적 공백을 매우기 위해 싱크 탱크(think tank)를 설립하고 학계와의 연계를 통해 인공지능의 특정 위험만이 아니라 시급한 법적 이슈에 관한 연구를 추진하기 시작하였다. 구글은 Deep Mind의 반복적인 요청에 따라 신기술을 검토하기 위하여 윤리위원회를 설치하였고, 마이크로소프트는 스탠포드 대학의 ‘인공지능에 관한 100년 연구 프로젝트(One Hundred Year Study on Artificial Intelligence)’에 재정지원을 하고 있으며, 자동화, 국가안보, 심리, 윤리, 법, 프라이버시, 민주주의 및 그 밖의 사회적 이슈를 검토하는 패널 구성에도 참여하고 있다. 보스톤에 위치한 Future of Life Institute(FLI)은 인공지능의 잠재적인 위험성과 편익에 관한 연구를 지원하기 위해 2014년 3월 출범한 기구이다. FLI는 2015년 1월 인공지능의 미래의 이익을 극대화하기 위한 연구 방향을 설정하기 위하여 컨퍼런스(The Future of AI: Opportunities and Challenges)를 개최하였다. 세계적으로 알려진 산업과 학계의 인공지능 전문가들과 법학, 경제학, 윤리학 전문가들이 한 자리에 모인 이 컨퍼런스에서 학회 참가자들은 기술의 오용을 예방하기 위해 보다 안전한 장치를 사용하고 신기술이 사회에 미치는 영향에 더욱 더 주의를 기울이기로 합의하였다. 이 학회 이후, 엘론 머스크, 스티브 호킹, 모르간 프리만, 알랜 알다는 FLI의 과학자문위원회의 위원직을 맡게 되었고, 인공지능을 “인류에 혜택”을 제공하는 기술로 유지시키기 위한(to keep AI “beneficial to humanity”) 글로벌 연구 프로그램의 재정지원을 위해 천만 불을 FLI에 기부하였다. 스탠포드 대학의 프로그램과 FLI는 인공지능의 미래와 위험에 관심을 갖는 수많은 국내외 싱크 탱크 및 협회들과 연계를 확대해나가고 있다. FLI는 강한 인공지능의 개발과 관련된 안전문제를 연구하는 UC 버클리 대학의 Machine Intelligence Research Institute과도 네트워크를 형성하였다. 지금까지 미국에서는 민간영역에서 자발적으로 인공지능의 안전 패러다임에 대한 논의를 형성해왔으며, 이 과정에서 정부의 참여를 직간접적으로 촉구해 왔다.

지난 5월 3일 미국 백악관 블로그에 “인공지능의 미래를 준비합니다(Preparing for the Future of Artificial Intelligence)”라는 제목의 글이 올라왔다. 백악관 과학기술정책실은 이글에서 학계, 비영리기구, 국가경제회의(National Economy Council)와 함께 인공지능에 관한 공론의 장을 워크숍 형식으로 연내 네 차례 마련하여 인공지능, 특히 기계 학습 기술이 제공하는 기회와 도전을 검토하겠다는 계획과 그 일정을 밝혔다. 최근 오바마 행정부는 백악관에 인공지능 이슈들을 다루기 위해 “기계학습과 인공지능 소위원회(Subcommittee on Machine Learning and Artificial Intelligence)”를 신설하였다. 이 소위원회는 인공지능 개발의 진보와 성과를 모니터링 하여 국가과학기술회의(National Science and Technology Council)에 보고하여야 한다. 이 임무를 수행하기 위해 첫 번째 미션으로 변형적 기술(transformative technology)인 인공지능이 일자리, 경제, 안전 및 규제에 미치는 영향을 일련의 워크숍에서 공개적으로 토론하고, 그 내용을 올해 말 보고서로 발간할 예정이다. 지난 5월 24일 시애틀에 위치한 워싱턴대학교에서 “인공지능의 법적‧거버넌스적 함의(Legal and Governance Implications of Artificial Intelligence)”라는 주제로 1차 워크숍이 진행되었다. 이어서 지난 6월 7일에는 워싱턴 D.C.에서 “사회적 선(善)을 위한 인공지능(Artificial Intelligence for Social Good)”이 논의되었다. 6월 28일에는 피츠버그에서 “인공지능의 안전과 통제(Safety and Control for Artificial Intelligence)”라는 주제로 토론하고, 마지막으로 7월 7일에는 뉴욕에서 “근접한 미래에 대한 인공지능기술의 사회적 경제적 함의(The Social and Economic Implications of Artificial Intelligence Technologies in the Near-Term)”를 차례로 논의할 예정이다.

인공지능에 관한 법적‧규제정책적 이슈들을 다룬 첫 번째 워크숍에서는 앞에서 지적한 바와 같이 강한 인공지능의 위험성보다는 약한 인공지능이 야기하는 문제들에 집중해야 하고, 정부의 역할이 요구된다는 데에는 많은 전문가들이 의견을 같이하였으나 그 역할의 구체적인 내용이나 정책 방향(이를 테면 구글의 자율주행자동차가 언제 어떻게 미국의 고속도로를 달리게 될지, 편견이 알고리즘에 스며드는 것을 어떻게 검토할 것인지 등)을 명확하게 제시하지는 못했다. 우리가 인공지능이라고 할 때 무엇을 의미하는지 정확한 정신적 모델을 가지고 있어야 한다는 의견이 있었고, 구체적 개별적인 정책적 법적 과제로 일자리 축소의 문제, 프라이버시, 데이터 관리, 국가의 개입방식, 도덕과 윤리 문제, 책임 등이 논의되었다. 이 가운데 두어 가지에 대해서만 언급하면, 규제의 문제에 대하여는 인공지능 기술은 아직 개발 중이므로 섣부른 정부의 개입은 더 안전하고 책임 있는 기계를 개발하는데 방해요인으로 작용할 수 있으며 개발자에게 공공의 안전을 책임지우는 부담으로 작용할 수 있다는 견해가 제시되었다. 이러한 인식을 공유하여서인지 미국 정부는 이미 상용중인 인공지능 –드론, 암 진단분석시스템– 에 대한 규제·감독에 집중하고 있으며, 이 과정에서도 여러 행정부처와 협력하여 증거에 기반한 신중한 접근을 하고 있는 중이다. 일자리 축소, 윤리와 도덕의 문제에 대해서는 앞으로 더 많은 일자리가 인공지능 프로그램에 의해 대체된다면, 그러한 프로그램을 설계하는 사람들에게 새로운 종류의 프로페셔널리즘(윤리기준)이 요구될 것이며, 그들은 그들의 직역에서 도덕적 부분을 인식하도록 훈련될 필요가 있다는 견해도 제시되었다. 인공지능 프로그램에 의한 차별(알고리즘의 편견)의 문제(예, 남성보다 여성에게 고소득 취업광고를 더 많이 전달하는 광고 프로그램, 흑인이 백인보다 상습범일 가능성이 더 높다고 평가하는 소프트웨어) 역시 프로그램 이면에 있는 사람이 윤리와 책임에 대해 보다 주의하여야 한다는 의견이 제시되었다. 이미 미국의 컴퓨터 전문가들은 공정성, 책임성, 투명성, 적법절차의 원칙들과 고된 씨름을 시작하였다고 한다.

미국 정부는 이 워크숍을 통해 인공지능 기술이 점점 더 복잡해지고 똑똑해지는 상황에서 그것을 안전하고, 통제가능하며, 예측 가능하도록 유지시키는 것은 매우 어려운 정책적 도전과제라는 점을 확인하였을 것이다. 인공지능의 현실적인 문제는 지능적인 기계가 인류를 지배할지 여부가 아니라 인간이 인공지능 기술을 타인을 지배하거나 억압하는 데 오용할 것인가이다. 적어도 현재와 근접한 미래에서 인공지능 자체는 큰 문제는 아닐 것이다. 현재의 인공지능 기술은 우리를 더 똑똑하게 만드는 한 방식에 불과하고, 더 많은 것을 더 빨리 알게 하는 수단에 불과하며, 우리의 문화와 가치의 확장을 돕는 도구에 불과할 뿐이다. 따라서 인공지능의 문제와 그에 대한 해결책은 “우리”이다. 따라서 인공지능이 초래할 수 있는 모든 종류의 현실적인 위험과 문제에 대한 법적 관심과 지향점은 “사람”이어야 할 것이다. 인공지능과 같은 첨단 기술을 다루면서 윤리와 도덕을 논하는 이유는 획기적인 법적 수단이 등장하기 전까지 모든 종류의 현실적인 위험과 문제로부터 일반 국민이 더 잘 보호될 수 있는 방식이 구식의, 기술적이지 않은 “사람으로서 마땅히 행하거나 지켜야 할 도리”를 일컫는 윤리와 “사회 구성원들이 양심, 사회적 여론, 관습 따위에 비추어 스스로 마땅히 지켜야 할 행동 준칙이나 규범의 총체”라고 정의되는 도덕이기 때문일 것이다.

——————————————————————————

<참고문헌>

RoboLaw(2014), 『D6.2 ‘Guidelines on Regulating Robotics』.

The White House(2014), 『Big Data: Seizing Opportunities, Preserving Values』.

The White House(2015), 『Big Data: Seizing Opportunities, Preserving Values Interim Progress Report』.

The White House(2016), 『Big Data: A Report on Algorithmic Systems, Opportunity, and Civil Rights』.

스티브 해리스(2015), 실현 가능한 궁극의 기술: 나노테크놀로지, 특이점, 그리고 인공지능 『스켑틱 코리아』, Vol. 3, 90-121.

피터 카산(2015), 인공지능이 실패할 수 밖에 없는 이유, 『스켑틱 코리아』, Vol. 3, 122-153.

보크 페리스(2015), 인공지능에 대한 낙관적 전망, 『스켑틱 코리아』, Vol. 3, 154-179.

Ariel Conn(2016), The White House Considers the Future of AI, Available:

April Glaser(2016), The White House is Finally Prepping for an AI-Powered Future, Available:

http://www.wired.com/2016/05/white-house-finally-prepping-ai-powered-future/

Agnese Smith(2015), Artificial Intelligence, Available: http://nationalmagazine.ca/Articles/Fall-Issue-2015/Artificial-intelligence.aspx

The White House(2016), Preparing for the Future of Artificial Intelligence, White House Blog, Available: https://www.whitehouse.gov/blog/2016/05/03/preparing-future-artificial-intelligence

이전 글

이전 글  다음 글

다음 글  「언론중재 및 피해구제 등에 관한 법률」 개정 동향 및 쟁점

「언론중재 및 피해구제 등에 관한 법률」 개정 동향 및 쟁점  ‘KISO 자율규제 백서 Vol.2’ 발간

‘KISO 자율규제 백서 Vol.2’ 발간  게임SW산업의 진흥과 자율규제 – 표현의 자유 관점에서의 규제 개선

게임SW산업의 진흥과 자율규제 – 표현의 자유 관점에서의 규제 개선  데이터산업법의 의미와 주요 쟁점

데이터산업법의 의미와 주요 쟁점  중국, 생성형 AI 서비스 제공자에 대한 저작권 침해 판결

중국, 생성형 AI 서비스 제공자에 대한 저작권 침해 판결  4차 산업혁명 관련 국내외 정책 및 입법 동향

4차 산업혁명 관련 국내외 정책 및 입법 동향  <청소년보호 특집①> 온라인서비스제공자(OSP)의 ‘청소년 음란물 차단 책임’ 위헌 심판 제청결정

<청소년보호 특집①> 온라인서비스제공자(OSP)의 ‘청소년 음란물 차단 책임’ 위헌 심판 제청결정  망 중립성을 둘러싼 불편한 진실

망 중립성을 둘러싼 불편한 진실