인공지능 규범을 둘러싼 글로벌 동향 및 시사점- EU인공지능법을 중심으로

1. 서론

인공지능을 둘러싼 글로벌 규범 경쟁(?)이 본격화되고 있다. EU는 2021. 4. 21. 인공지능법 초안1 을 발의했고 EU 이사회는 2024. 5. 21(현지시각), 전 세계 최초로 AI 법안(Regulation Laying Down Harmonised Rules on Artificial Intelligence, 이하 ‘EU 인공지능법’)을 통과시켰다. 강한 규제를 통해 미국의 AI 주도권에 대한 경계를 반영하고자 한 것이라는 분석도 제기된다.2 미국 역시 2023년 10월, 미국 조 바이든 대통령이 AI 규제책이 담긴 행정명령에 서명했다.3 기업이 AI 개발 과정에서 미국 표준 기술 연구소(NIST)에서 실시하는 AI 안전 테스트를 시행하고, 그 결과와 개발 과정에서의 민감 정보를 정부에 보고하도록 하는 내용 등이 담겼다. 한편 2025년 5월 개최된 ‘AI 서울 정상회의’의 시초로써 2023년 11월 영국에서는 각 국가의 행정부, 산업계, 학계, 시민 사회 등을 대표하는 약 150명이 참석한 ‘제1회 AI 안전 정상회의’가 열렸다. 이 회의에서는 AI 시스템이 오용되거나 인간의 통제를 벗어날 위험에 관해 논의했고 그 결과 ‘블레츨리 선언’이 발표됐다. 선언문은 고도의 능력을 갖춘 범용 AI 모델을 ‘프론티어 AI’로 정의하며 위험에 대응하기 위해 AI 안전 위험을 식별하고, 이를 기반으로 정책을 개발하며, AI 안전성에 관한 국제적 연구 네트워크를 지원하는 내용을 포함하고 있다.4

이처럼 AI생태계에 영향력을 발휘할 수 있는 EU, 미국 등을 중심으로 AI규범 이슈가 본격적으로 논의되고 있다. 특히 EU 인공지능법은 본격 시행을 앞두고 있는바,5 시장에 미칠 파장을 예측하고 대응할 필요가 있다. 이하에서는 EU 인공지능법 등을 중심으로 글로벌 규범 동향을 검토하고 시사점을 모색해 보고자 한다.

2. EU 인공지능법 주요내용

가. 입법 배경 및 적용 범위

이 법은 인공지능 시스템의 유해한 영향으로부터 민주주의와 법치주의 및 환경 그리고 헌장에 명시된 기본권, 건강, 안전을 높은 수준으로 보호하고 혁신을 지원하면서 인간 중심적이고 신뢰할 수 있는 인공지능의 활용을 촉진하고 내부 시장의 기능을 개선하는 것을 목적으로 한다.6 본 규정은 유럽연합 내 또는 제3국에 설립됐는지 여부와 관계없이 다음과 같은 인공지능 시스템 제공자와 유럽연합 내에 설립된 인공지능 시스템 배포자에게 적용된다.7 또한 해당 활동을 수행하는 주체의 유형과 관계없이 군사, 국방 또는 국가 안보 목적으로만 시장에 출시 또는 서비스되는 경우 적용되지 않는다. 더불어 제3국의 공공 기관 또는 일정한 요건의 국제기구에 적용되지 않는다. 그리고 해당 기관 또는 조직이 유럽연합 또는 하나 이상의 회원국과의 법 집행 및 사법 협력을 위한 국제 협력 또는 협약의 틀 안에서 인공지능 시스템을 사용하는 경우, 해당 제3국 또는 국제기구가 개인의 기본권 및 자유 보호와 관련하여 적절한 안전장치를 제공한다는 조건하에 적용되지 않는다.8

그리고 이 법은 과학적 연구 및 개발만을 목적으로 특별히 개발돼 서비스에 투입된 AI 시스템 및 모델(그 결과물 포함)에는 적용되지 않는다.9 또한 시장에 출시되거나 서비스에 투입되기 전의 AI 시스템 또는 모델에 관한 연구, 테스트 및 개발 활동에는 적용되지 않는다. 그러나 실제 환경에서의 테스트는 이 법의 적용을 받는다.10 또한 순전히 개인적인 비전문적 활동의 일환으로 AI 시스템을 사용하는 자연인인 배포자에게는 이 법이 적용되지 않는다.11

무료 라이선스 혹은 오픈 소스 라이선스로 제공되는 AI 시스템 역시 적용이 제외된다(단 허용되지 않는 위험 혹은 고위험 AI 시스템에 해당하거나 동 규정의 규제 대상인 GPAI에 해당하는 경우는 제외한다).12

나. 금지된 AI(Article 5 : Prohibited Artificial Intelligence Practices)

1) 인공지능이 조작, 착취, 사회 통제를 위한 도구로 사용되는 경우

연령, 장애 또는 특정 사회적 또는 경제적 상황으로 인해 개인 또는 특정 그룹의 취약성을 악용해 해당 개인 또는 해당 그룹과 관련된 사람의 행동을 심각하게 왜곡하여 해당 개인 또는 다른 사람에게 심각한 피해를 주거나, 그럴 가능성이 있는 방식으로 영향을 미칠 목적으로 또는 그러한 영향을 미치는 AI 시스템을 시장에 출시, 서비스에 투입 또는 사용하는 행위는 금지된다.13) AI를 이용한 조작 기술은 사람들이 원치 않는 행동에 참여하도록 설득하거나, 자율성, 의사결정 및 자유로운 선택을 손상시키는 방식으로 결정을 내리도록 유도해 사람들을 속이는 데 사용될 수 있다. 특히 신체적, 심리적 건강 또는 금전적 이익에 악영향을 미칠 수 있는 중대한 피해, 즉 인간의 행동을 실질적으로 왜곡할 목적 또는 그 효과를 가진 특정 AI 시스템을 시장에 출시하거나 서비스에 투입하거나 사용하는 것은 특히 위험하므로 금지돼야 한다는 취지다. 예를 들어, 기계-뇌 인터페이스나 가상현실은 사람에게 제시되는 자극을 더 높은 수준으로 제어할 수 있게 해주기 때문에 사람의 행동을 현저히 해로운 방식으로 왜곡할 수 있다. 또한, AI 시스템은 연령, 지침(EU) 2019/882의 의미에 따른 장애, 극빈층, 소수 민족 또는 종교적 소수자 등 착취에 더 취약할 수 있는 특정 사회적 또는 경제적 상황으로 인해 개인 또는 특정 그룹의 취약점을 악용할 수도 있다. 이러한 AI 시스템은 사람의 행동을 실질적으로 왜곡할 목적(또는 그 효과를 목적)으로, 그리고 시간이 지남에 따라 누적될 수 있는 피해를 포함해 해당 사람이나 다른 사람 또는 집단에 심각한 피해를 유발하거나 유발할 가능성이 있는 방식으로 시장에 출시되거나 서비스에 투입되거나 사용될 수 있으므로 금지돼야 한다는 것이다. 특히 소비자에게 경제적 또는 재정적 피해를 초래하는 불공정 관행은 AI 시스템을 통해 이루어지든 그렇지 않든 관계없이 모든 상황에서 금지된다. 그러나 광고 분야와 같이 해당 법률을 준수하는 일반적이고 합법적인 상업적 관행은 그 자체로 유해한 조작적 AI 관행에 해당하는 것으로 간주되어서는 안된다.14)

2) 개인의 생체 데이터를 기반으로 하는 생체인식 분류 시스템15)

개인의 얼굴이나 지문을 이용하여 정치적 의견, 노동조합 가입 여부, 종교적 또는 철학적 신념, 인종, 성생활 또는 성적 지향을 추론하거나 유추하는 행위는 금지된다. 이 금지 조항은 예를 들어 법 집행 영역에서 사용될 수 있는 머리 색깔이나 눈 색깔에 따른 이미지 분류와 같이 유럽연합 또는 국내법에 따라 획득한 생체 인식 데이터 세트의 합법적인 라벨링, 필터링 또는 분류에는 적용되지 않는다.

3) 사회적 점수를 제공하는 시스템16)

자연인 또는 그 집단의 사회적 행동 또는 알려지거나 추론·예측된 개인적 특성을 기반으로 일정기간 그들을 평가 또는 분류하도록 만들어진 AI 시스템을 시장에 출시, 서비스 또는 사용하는 행위는 금지된다. AI 시스템은 다양한 맥락에서의 사회적 행동과 관련된 여러 데이터를 기반으로 또는 특정기간 알려진, 추론·예측된 특성을 기반으로 자연인 또는 그 집단을 평가하거나 분류한다. 자연인에 대한 사회적 점수를 제공하는 AI 시스템은 차별적인 결과를 초래하고 특정 그룹을 배제할 수 있다. 이는 존엄성과 차별 금지에 대한 권리, 평등과 정의의 가치를 침해할 수 있다. 이러한 AI 시스템에서 얻은 사회적 점수는 데이터가 원래 생성되거나 수집된 맥락과 무관하게 사회적 맥락에서 자연인 또는 그 그룹 전체를 불리하게 대우해 정당하지 않은 결과를 초래할 수 있다. 따라서 자연인 또는 그 집단의 사회적 행동 또는 이미 알려진 혹은 추론·예측된 개인 또는 집단을 일정한 기간 동안 평가 또는 분류하기 위해 AI 시스템을 시장에 출시, 서비스 또는 사용하는 행위는 금지된다.

4) 법 집행 목적으로 식별을 위한 원격 생체인식 시스템(실시간 원격 생체인식 시스템)의 사용17)

이러한 시스템을 법 집행의 목적으로 사용하는 것은 반드시 필요한 예외적인 경우가 아니고서는 금지된다. 그러나 다음과 같은 예외적인 상황은 허용된다.

i) 납치, 인신매매, 성 착취의 특정 피해자를 찾고 실종자를 수색하는 것,

ii) 자연인의 생명 또는 신체적 안전에 대한 구체적이고 실질적이며 임박한 위협 또는 실질적이고 현존하는 또는 실질적이고 예측 가능한 테러 공격의 위협을 방지하기 위한 목적으로 사용하는 것

iii) 해당 회원국에서 최소 4년 이상의 구금형 또는 구금 명령으로 처벌할 수 있고 해당 회원국의 법률에 정의된 대로 부속서 IIa18에 언급된 범죄의 가해자 또는 용의자의 위치 파악 또는 신원 확인하기 위해 사용하는 것

그러나 이러한 예외적 사용은 사법 당국(또는 독립 행정 당국)의 명시적이고 구체적인 허가, 즉 사전 승인을 받아야 한다. 다만 정당한 긴급한 상황, 즉 해당 시스템을 사용하기 전에 승인을 얻는 것이 객관적으로 불가능한 경우 사후 승인이 허용된다, 이러한 긴급 상황은 필요 최소한으로 제한되어야 하며, 적절한 안전장치가 전제돼야 한다. 또한 법 집행 기관은 이러한 상황에서 그러한 승인을 요청할 때 지체없이, 즉 늦어도 24시간 이내에, 요청할 수 없는 사유를 제시하면서 승인을 요청해야 한다. 그러한 승인이 거부되면 해당 승인과 관련된 실시간 생체 인식 시스템의 사용을 즉시 중단하고 해당 사용과 관련된 모든 데이터를 폐기 및 삭제해야 한다.

5) 범죄 위험 예측, 평가

자연인의 프로파일링 또는 성격 특성을 기반으로 자연인이 범죄를 저지를 위험을 평가하거나 예측하기 위해 AI 시스템을 시장에 출시하거나 이러한 특정 목적을 위해 서비스에 투입. 사용하는 행위는 금지된다.19)

다만 이 금지 조항은 다음을 지원하는 데 사용되는 AI 시스템에는 적용되지 않는다.

– 범죄 행위와 직접적으로 연관된 객관적이고 검증 가능한 사실에 근거하여 개인의 범죄 행위 연루 여부에 대한 인적 평가

– 인터넷이나 CCTV 영상에서 표적화되지 않은 얼굴 이미지를 스크랩하여 얼굴 인식 데이터베이스를 생성하거나 확장하는 AI 시스템을 사용하는 행위(the untargeted scraping of facial images from the internet or CCTV footage)

– 의료 또는 안전상의 이유로 AI 시스템을 사용하거나 시장에 출시하려는 경우를 제외하고 직장 및 교육 기관의 영역에서 자연인의 감정을 추론하기 위해 AI 시스템을 시장에 출시하거나 이러한 특정 목적을 위해 서비스에 투입하거나 사용하는 행위.

다. 고위험 AI 시스템(High-Risk AI Systems)

1) 개념과 요건

고위험으로 식별된 인공지능 시스템은 사람의 건강, 안전 및 기본권에 중대한 해로운 영향을 미치는 시스템을 의미한다. 고위험 AI 시스템은 특정 의무 요건을 준수하는 경우에만 시장에 출시하거나 서비스를 제공하거나 사용할 수 있다.

두 가지 요건을 충족해야 하는 데 우선 (a) AI 시스템이 제품의 안전 구성 요소로 사용되거나 AI 시스템 자체가 부속서 II20에 나열된 유럽연합 조화 법규의 적용을 받는 제품인 경우이어야 하며 (b) (a)항에 따른 안전 구성 요소가 AI 시스템인 제품에 해당되는 경우 또는 AI 시스템 자체가 제품인 경우에는 부속서 II에 따라 제3자 적합성 평가를 거쳐야 한다.21

그리고 이러한(제1항) 고위험 AI 시스템 외에도 부속서 III에 규정된 AI 시스템도22 고위험으로 간주한다. 다만 인공지능 시스템이 의사결정 결과에 중대한 영향을 미치지 않는 등 자연인의 건강, 안전 또는 기본권에 중대한 위해를 가할 위험이 없는 경우에는 고위험으로 간주하지 않는다. 이렇게 고위험에 해당하지 않기 위해서는 해당 AI 시스템이 다음 기준 중 하나 이상을 충족하는 경우이어야 한다.

(a) 절차적 작업을 수행하기 위한 것인 경우

(b) 이전에 완료된 인간 활동의 결과를 개선하기 위한 것인 경우

(c) AI 시스템은 의사결정 패턴 또는 이전 의사결정 패턴과의 편차를 감지하기 위한 것이며, 적절한 사람의 검토 없이 이전에 완료된 사람의 평가를 대체하거나 영향을 미치지 않는 경우

(d) AI 시스템은 부록 III에 나열된 목적과 관련된 평가를 위한 준비 작업을 수행하기 위한 것인 경우

그럼에도 불구하고, AI 시스템이 자연인의 프로파일링을 수행하는 경우 항상 고위험군으로 간주 된다.

2) 준수사항

(1) 위험관리시스템 구축23

위험 관리 시스템은 고위험 AI 시스템의 전체 수명 주기 동안 계획되고 실행되는 지속적인 반복 프로세스다. 주요 내용은 다음과 같다.

(a) 고위험 AI 시스템이 의도된 목적에 따라 사용될 때 건강, 안전 또는 기본권에 미칠 수 있는 위험을 식별

(b) 고위험 AI 시스템이 의도된 목적에 따라 사용될 때 나타날 위험을 추정 및 평가

(c) 모니터링 시스템에서 수집한 데이터 분석을 기반으로 기타 발생할 수 있는 위험에 대하여 평가

(d) 식별된 위험을 해결하기 위해 고안된 적절하고 목표 지향적인 위험 관리 조치를 채택

(2) 데이터 및 데이터 거버넌스 개발24

고위험 AI 시스템은 품질기준을 충족하는 데이터세트를 기반으로 개발되어야 한다. 데이터에 의해 초래될 사람의 건강과 안전, 기본권에 부정적인 영향이나 유럽연합 법률에 따라 금지된 차별을 초래할 수 있는 편견의 가능성을 검토하고 이를 막기 위한 적절한 조치를 취해야 한다.

(3) 기술문서 작성25

고위험 AI 시스템의 기술 문서는 해당 시스템이 시장에 출시되거나 서비스에 투입되기 전에 작성돼야 하며 최신성을 유지해야 한다.

기술문서는 고위험 AI 시스템에 부여된 요건을 준수하고 있음을 입증하는 방식으로 작성되어야 한다. AI 시스템의 요건준수를 평가하는 데 필요한 정보를 명확하고 포괄적인 형태로 소관 정부 기관(및 신고 기관)에 제공해야 한다. 여기에는 최소한 부속서 IV에 명시된 요소26가 포함되어야 한다. 스타트업을 포함한 중소기업은 부속서 IV에 명시된 기술문서를 간소화된 방식으로 제공할 수 있다. 이를 위해 위원회는 중소기업의 요구에 맞는 간소화된 기술문서 양식을 마련해야 한다.

(4) 기록보관27

고위험 AI 시스템은 기술적으로 이벤트(‘로그’)의 자동 기록을 가능하게 해야 한다. 즉 시스템의 목적에 적합하게 AI 시스템 기능이 이루어지고 있음을 보장하기 위해 로깅 기능을 통해 관련 사건을 기록할 수 있어야 한다.

부록 III의 1항 (a)호에 언급된 고위험 AI 시스템의 경우, 로깅 기능은 최소한 (a)시스템 사용 기간 기록(각 사용의 시작 날짜와 시간, 종료 날짜와 시간), (b) 시스템에서 입력 데이터를 확인한 참조 데이터베이스, (c) 검색 결과와 일치하는 입력 데이터, (d) 제14조 5항에 언급된 바와 같이 결과 확인에 관련된 자연인의 신원 확인에 대한 기록 기능을 제공해야 한다.

(5) 투명성 및 정보제공28

AI 시스템은 배포자가 시스템의 출력을 해석하고 적절하게 사용할 수 있도록 설계 및 개발되어야 한다. 사용자가 접근 가능하며 이해할 수 있는 간결하고 완전하며 정확하고 명확한 정보가 포함된 적절한 디지털 형식 또는 기타 사용 지침이 함께 제공되어야 한다.

해당 지침에는 다음의 사항이 포함되어야 한다.

(a) 제공업체의 신원 및 연락처 정보, 해당되는 경우 대리인의 연락처 정보

(b) 고위험 AI 시스템의 특성, 기능 및 성능의 한계

(c) 최초 적합성 평가 시점에 공급자가 미리 결정한 고위험 AI 시스템 및 그 성능에 대한 변경 사항(있는 경우)

(d) 배포자가 AI 시스템의 결과물을 쉽게 해석할 수 있도록 마련한 기술적 조치를 포함하여 제14조에 언급된 인적 감독 조치

(e) 필요한 컴퓨팅 및 하드웨어 리소스, 고위험 AI 시스템의 예상 수명, 소프트웨어 업데이트를 포함하여 해당 AI 시스템의 적절한 기능을 보장하기 위해 필요한 유지관리 및 관리 조치(빈도 포함)

(ea) 해당되는 경우, 사용자가 제12조에 따라 로그를 적절하게 수집, 저장 및 해석할 수 있도록 AI 시스템 내에 포함된 메커니즘에 대한 설명.

(6) 사람의 감독29

고위험 AI 시스템은 적절한 인간-기계 인터페이스 도구를 포함하여 AI 시스템을 사용하는 기간 동안 자연인이 효과적으로 감독할 수 있는 방식으로 설계 및 개발되어야 한다. 특히 부록 III의 1(a)항에 언급된 고위험 AI 시스템의 경우, 제3항에 언급된 감독 조치는 필요한 역량, 훈련 및 권한을 갖춘 최소 2명의 자연인이 별도로 검증하고 확인해야 한다.

(7) 정확성, 견고성 및 사이버 보안30

고위험 AI 시스템은 적절한 수준의 정확성, 견고성, 사이버 보안을 갖추어야 하고 수명 주기 동안 이러한 측면에서 일관되게 작동하도록 설계 및 개발돼야 한다. 적절한 수준의 정확성과 견고성을 측정하는 방법 및 기타 관련 성과 지표의 기술적 측면을 해결하기 위해 위원회는 관련 이해관계자 및 기관과 협력하여 측정 방법론의 개발을 적절히 장려해야 한다.

고위험 AI 시스템은 시장에 출시되거나 서비스에 투입된 후에도 계속 학습하는 경우 적절한 완화 조치를 통해 향후 입력에 영향을 미칠 수 있는 편향된 출력(‘피드백 루프’)의 위험을 최대한 제거하거나 줄일 수 있는 방식으로 개발돼야 하며, 적절한 완화 조치를 통해 대응해야 한다.

(8) 품질 관리 시스템 구축 및 문서보관31 : 시스템 제공자의 의무

고위험 AI 시스템 제공자는 본 규정을 준수할 수 있는 품질 관리 시스템을 구축해야 한다. 이러한 시스템은 서면 정책, 절차 및 지침의 형태로 체계적이고 질서 있게 문서화되어야 하며, 최소한 이 규정에서 정한 사항을 포함해야 한다.

그리고 AI 시스템이 시장에 출시되거나 서비스에 들어간 후 10년 동안 (a) 제11조의 기술문서와 (b) 제17조의 품질 관리 시스템에 관한 문서 (c)인증기관이 승인(또는 변경)한 문서를 추후 정부가 처리(disposal)할 수 있도록 보관해야 한다.

(9) 자동생성로그 보관 의무32

고위험 AI 시스템 제공자는 고위험 AI 시스템에서 자동으로 생성되는 제12조 1항에 언급된 로그를 자신의 통제하에 보관해야 한다. 유럽연합 또는 국내법을 침해하지 않는 범위 내에서, 유럽연합 또는 국내법, 특히 개인정보보호에 관한 유럽연합 법률에서 달리 규정하지 않는 한 고위험 AI 시스템의 사용 목적에 적합한 기간인 최소 6개월 동안 로그를 보관해야 한다.

유럽연합 금융 서비스 법률에 따라 내부 거버넌스, 계약 또는 프로세스에 관한 요건을 준수해야 하는 금융 기관인 제공업체는 고위험 AI 시스템에서 자동으로 생성된 로그를 관련 금융 서비스 법률에 따라 보관해야 한다.

(10) 시정조치 및 정보제공 의무33

시장에 출시하거나 서비스에 투입한 고위험 AI 시스템이 본 규정을 준수하지 않는다고 생각하거나 그렇게 생각할 이유가 있는 고위험 AI 시스템 제공자는 즉시 해당 시스템을 준수하기 위해 필요한 시정조치를 취하고, 철회, 비활성화 또는 리콜하는 등 적절한 조치를 취해야 한다. 고위험 AI 시스템의 유통업체와 배포자, 공인 대리인 및 수입 업체에도 해당 사실을 알려야 한다.

(11) 고위험 AI 시스템에 대한 기본권 영향평가34

부속서 Ⅲ의 235에 열거된 영역에서 사용하려는 인공지능 시스템, 공법의 적용을 받는 기관 또는 공공 서비스를 제공하는 민간사업자인 배포자, 부속서 Ⅲ의 5 (b)36 및 (ca)37에 언급된 고위험시스템을 배포하는 사업자는 시스템 사용으로 인해 발생할 수 있는 기본권에 대한 영향 평가를 수행해야 한다. 기본권 영향평가는 다음의 항목으로 구성되어야 한다.

(a) 고위험 AI 시스템이 의도된 목적에 부합하게 사용될 수 있는 프로세스

(b) 각 고위험 AI 시스템이 사용하려는 기간과 빈도

(c) 특정 상황에서 사용으로 인해 영향을 받을 가능성이 있는 자연인 및 그룹의 범주

(d) 제13조에 따라 제공자가 제공한 정보를 고려하여 (c)항에 따라 식별된 사람 또는 사람 그룹에 영향을 미칠 수 있는 구체적인 피해, 위험

(e) 사용 지침에 따른 인적 감독 조치의 이행에 대한 설명

(f) 내부 거버넌스 및 불만 처리 메커니즘을 포함하여 이러한 위험이 현실화될 경우 취해야 할 조치

규정 (EU) 2016/679 제35조 또는 지침 (EU) 2016/680 제27조에 따라 수행된 데이터 보호 영향 평가를 통해 본 조에 명시된 의무가 이미 충족된 경우, 기본권 영향 평가는 해당 데이터 보호 영향 평가와 함께 수행돼야 한다.

(12) 적합성 평가

적합성 평가는 크게 i) 부록 VI의 내부 통제에 기반한 적합성 평가와 ii)부록 VII에 규정된 인증기관의 참여를 통한 적합성 평가로 나눠진다.

부록 III의 2~8번 항목에 언급된 고위험 AI 시스템 제공자는 부록 VI의 내부통제에 기반한 적합성 평가 절차를 따라야 한다. 이러한 경우 인증기관의 개입이 요구되지 않는다. 이미 적합성 평가 절차를 거친 고위험 AI 시스템은 수정될 때마다 새로운 적합성 평가 절차를 거쳐야 한다. 적합성 평가에 대한 인증서는 명시된 기간 동안 유효하며, 부속서 II에 적용되는 AI 시스템의 경우 5년, 부록 III에 적용되는 AI 시스템의 경우 4년을 초과하지 않아야 한다.38

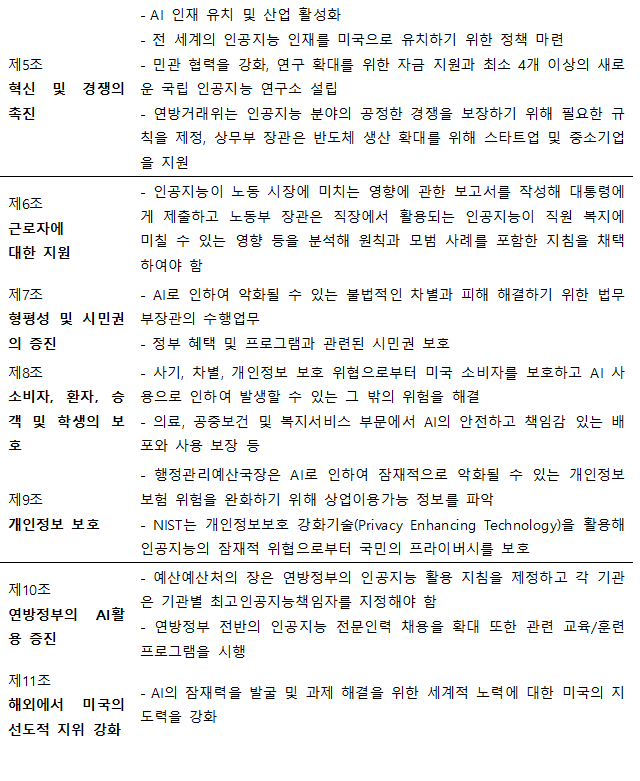

라. 특정 AI 시스템의 제공자 및 배포자에 대한 투명성 의무39

1) 인공지능 생성물임을 표시할 의무

GPAI 시스템을 포함하여 합성 오디오, 이미지, 동영상 또는 텍스트 콘텐츠를 생성하는 인공지능 시스템 제공자는 인공지능 생성물임을 인식할 수 있도록 조치를 취해야 하며 이러한 조치는 기계가 읽을 수 있는 형식으로 표시돼야 한다. 단 이러한 의무는 AI 시스템이 표준 편집을 위한 보조 기능을 수행하거나 배포자가 제공한 입력 데이터 또는 그 의미를 실질적으로 변경하지 않는 경우 또는 법률에 의해 범죄를 탐지, 예방, 조사 및 기소하도록 허가된 경우에는 적용되지 않는다.

2) 개인정보 처리 시 주의의무

감정 인식 시스템 또는 생체 인식 분류 시스템의 배포자는 해당 시스템에 노출된 자연인에게 시스템 작동에 대해 알리고, 해당되는 경우 EU법(Regulation (EU) 2016/679, Regulation (EU) 2016/1725 및 Directive (EU) 2016/280)에 따라 개인정보를 처리해야 한다. 이러한 의무는 제3자의 권리와 자유에 대한 적절한 보호 조치를 취하고 유럽연합 법률에 따라 범죄를 탐지, 예방 및 조사하기 위해 법으로 허용되는 생체 인식 분류 및 감정 인식에 사용되는 AI 시스템에는 적용되지 않는다.

3) 딥페이크 사실의 공지

딥페이크에 해당하는 이미지, 오디오 또는 동영상 콘텐츠를 생성하거나 조작하는 AI 시스템의 배포자는 해당 콘텐츠가 인위적으로 생성 또는 조작됐다는 사실을 공개해야 한다. 다만 이러한 의무는 범죄 행위를 탐지, 예방, 수사 그리고 기소하기 위해 법령에 의해 그 사용이 허가된 경우에는 적용되지 않는다. 또한 콘텐츠가 명백히 예술적, 창작적, 풍자적, 허구의 저작물 또는 프로그램 유사 콘텐츠의 일부를 구성하는 경우, 이 항에 명시된 투명성 의무는 저작물의 전시 또는 향유를 방해하지 않는 적절한 방식으로 그러한 생성 또는 조작된 콘텐츠의 존재를 알리도록 제한된다.

마. GPAI(General purpose AI models)(Articles 52a – 52e)40

1) 시스템 위험(systemic risk)이 있는 GPAI41의 지정절차

GPAI(general purpose AI models)는 다음 기준 중 하나를 충족하는 경우 시스템적 위험이 있는 GPAI 모델로 분류된다.42

(a) 적절한 기술적 수단과 방법론(지표와 벤치마크를 포함한)을 기반으로 높은 영향력 역량(high impact capabilities)을 가지고 있다고 평가된 경우

(b) 위원회 또는 과학 패널의 결정에 따라 범용 AI 모델이 (a)와 동등한 역량 또는 영향력을 가지고 있다고 인정한 경우

GPAI 모델은 부동 소수점 연산(FLOP)으로 측정한 훈련에 사용된 누적 계산량이 10∼25보다 큰 경우 제52a조.1.(a)에 따라 높은 영향력을 가진 것으로 추정된다.43

GPAI 모델이 시스템적 위험이 있는 GPAI 모델 요건을 충족하는 경우, 관련 제공자는 해당 요건을 충족하거나 해당 요건을 충족할 것이라는 사실이 알려진 후 2주 이내에 지체 없이 위원회에 통지해야 한다. 해당 통지에는 관련 요건이 충족되었음을 입증하는 데 필요한 정보가 포함되어야 한다. 위원회는 통지되지는 않았으나 시스템적 위험을 초래하는 혜먀 모델을 인지하게 되면 이를 시스템적 위험이 있는 모델로 지정할 수 있다.44

시스템적 위험이 있는 GPAI 모델 요건(제52a조제1항(a)에 규정된 요건)을 충족하는 GPAI 모델 제공자는 예외적으로 해당 요건을 충족하더라도 해당 GPAI 모델의 특성으로 인해 시스템적 위험이 존재하지 않으므로 시스템적 위험이 있는 GPAI 모델로 분류되어서는 안 된다는 것을 입증하는 충분한 근거를 신고서와 함께 제시할 수 있다.45 위원회는 이러한 주장이 충분히 입증되지 않았고 해당 사업자가 GPAI 모델의 그러한 특성으로 인해 시스템적 위험이 존재하지 않는다는 것을 입증하지 못했다고 판단하는 경우, 해당 주장을 거부하고 해당 GPAI 모델을 시스템적 위험이 있는 GPAI 모델로 간주한다.46

2) GPAI 모델 제공업체의 의무사항47

(1) 기술문서 작성

훈련 및 테스트 과정과 평가 결과를 포함한 모델의 기술 문서를 작성하고 최신성을 유지하며, 요청 시 인공지능 사무국 및 국가 관할 당국에 제공하도록 기술문서에는 부속서 IXa에 명시된 요소를48 포함해야 한다.

(2) 제공문서 작성

GPAI을 AI시스템에 통합하려는 자는 AI시스템 정보 및 문서를 작성하고 최신성을 유지하며 이를 통합하려는 AI 시스템 제공업체에게 제공하여야 한다. 역시 이러한 문서에는 최소한 부록 IXb에 명시된 요소49를 포함해야 한다.

(3) 저작권 존중 의무

유럽연합 저작권법을 존중하기 위한 정책을 마련해야 한다.

(4) 학습콘텐츠에 대한 정보 제공 의무

AI 사무국 템플릿에 따라 범용 AI 모델의 학습에 사용된 콘텐츠에 대해 충분히 상세한 요약을 작성해 공개적으로 제공해야 한다.

3) 시스템적 위험이 있는 GPAI 모델 제공자의 추가적 의무 사항50

제52c조에 나열된 의무 외에도, 시스템적 위험이 있는 범용 AI 모델 제공자는 다음과 같은 의무를 준수해야 한다.

(1) 모델 평가 수행

시스템 리스크를 식별하고 완화하기 위해 모델에 대한 적대적 테스트(adversarial testing)를 수행하고 문서화하는 등 최신 기술을 반영하는 표준화된 프로토콜 및 도구에 따라 모델 평가를 수행해야 한다.

(2) 시스템적 위험(출처 포함)을 평가하고 완화

시스템적 위험이 있는 GPAI 모델의 개발, 시장 출시 또는 사용으로 인해 발생할 수 있는 시스템적 위험(출처 포함)을 평가하고 완화해야 한다.

(3) 시정조치 등

심각한 사고와 이를 해결하기 위한 가능한 시정조치에 대한 관련 정보를 추적하고 문서화하여 AI 사무국과 관할 당국에 지체없이 보고하여야 한다.

(4) 사이버 보안

시스템적 위험이 있는 GPAI 모델과 그러한 모델의 물리적 인프라에 대해 적절한 수준의 사이버 보안 보호를 보장해야 한다.

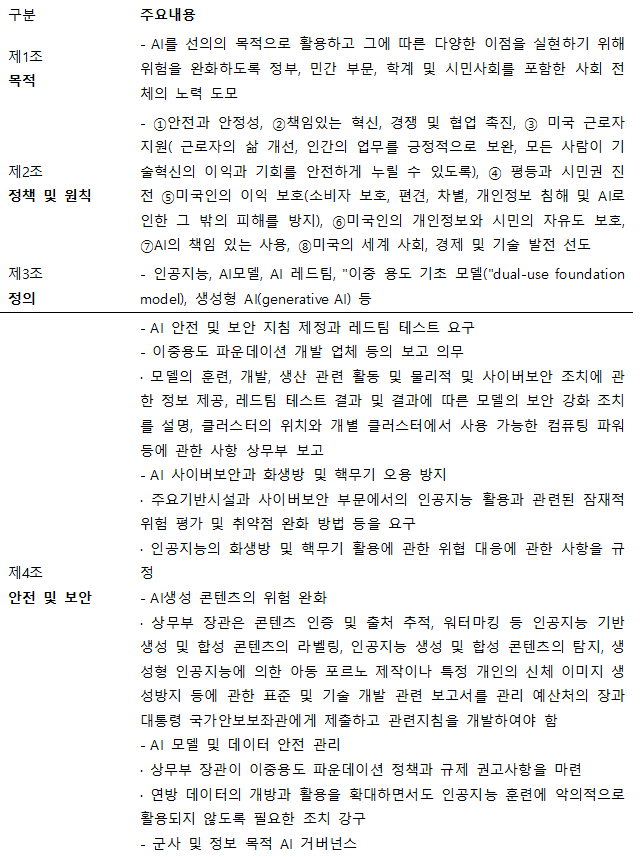

3. 미국 바이든 행정명령

EU 인공지능법에 앞서 미국 바이든 정부는 2023년 10월 30일 안전하고 신뢰할 수 있는 인공지능의 개발 및 이용에 관한 행정명령 14110호(Executive order on the Safe, Secure, and Trustworthy Development and Use of Artificial Entelligenve, 이하 ‘바이든 행정명령’)를 발표했다.51 이는 국가안보, 건강, 안전을 위협하는 AI 기술 개발과 이용을 규제하겠다는 것이 핵심이며, 63페이지 분량의 총 8개 부분으로 구성돼 있다. AI 개발 기업의 안전성 평가 의무화, AI 도구의 안전성 표준 마련, 콘텐츠 인증표준 수립과 개인 정보보호 등에 관한 내용을 담고 있다.52

4. 시사점

가. 규제에 앞서 우리의 기술 수준과 산업에 대한 면밀한 분석이 선행되어야.

현재 AI 시장에서 주류를 점하고 있는 언어 모델53은 방대한 양의 데이터를 사전 학습한 대형 언어 모델(LLM, Large Language Model)을 기반으로 한다. 따라서 AI 서비스 개발 과정에는 데이터와 컴퓨팅 자원이 필수적이다. 생성형 AI 서비스에는 크게 AI학습 비용, 미세 조정(fine tuning) 비용, 서비스 운영 비용 등이 소요되는데 고정 비용에 해당하는 학습 비용의 투자 여력에 따라 서비스의 성능이 결정된다.54 예를 들어, GPT-4의 학습 비용은 약 1억 달러로 추정되며55), 구글 딥마인드의 Gemini는 약 6억3천만 달러가 소요됐을 것으로 추정된다.56) 한편 현재 글로벌 규제 논의에 중점적 역할로 참여하고 있는 기업은 2023년 기준으로 전 세계 AI 도구 시장 점유율 1위57)를 차지하고 있는 오픈AI를 비롯해, 구글, 마이크로소프트, 앤트로픽 등 ‘프론티어 모델 포럼(Frontier Model Forum, 이하 FMF)58’ 소속 기업들이다. 이들은 미국 표준 기술 연구소(NIST)에서 구성한 미국 AI 안전 연구소 컨소시엄(AISIC)의 창립 멤버로 합류했는데, AISIC은 AI 생태계 이해관계자가 참여해 AI 시스템의 안전성을 평가하고 보장하기 위한 방법론과 표준, 지침 등을 개발하는 것을 목적으로 200여 개 주요 기업을 포함하는 컨소시엄으로서 2024년 2월 창립됐다.59) AISIC은 ‘바이든 행정명령’과도 밀접하게 관련된다.

이미 학습된 LLM 모델은 폐쇄형 API를 통해 접근이 제한되므로 AI 기술을 사용하고자 하는 연구자나 기업의 경우 프론티어 AI 기업이 제공하는 상용 API를 사용해야 한다. 이는 결국 프론티어 AI 기업들의 지배력을 강화시키며,60 이들이 막강한 지배력을 이용해 각종 규제 정책에 영향을 미치게 된다.

반면 우리나라가 AI산업 생태계에서 차지하는 비중은 지극히 미약하다. 이러한 글로벌 기업과 시장을 보유한 국가와 차별화된 발전전략이 필요하다.

나. 해외 규범의 구체적 시행 방법과 효과를 주목할 필요

최근 생성형 인공지능은 우리의 일상에서 그 영향력과 위력을 고스란히 보여주고 있다. 2021년 EU 인공지능법 초안에는 GPAI에 관한 규정이 포함되지 않았으나 3차 합의안에 새로이 추가됐다. GPAI 모델 관련 부과된 새로운 의무들, 상세한 기술문서 작성, 저작권법의 존중 정책 마련 등은 앞으로 유럽시장을 겨냥한 업체들이 직면해야 하는 중요한 과제다. 특히 유럽 AI 사무국에서 제공하는 템플릿을 기반으로 GPAI 모델 학습에 사용된 콘텐츠에 대한 상세한 요약을 공개적으로 제공해야 하므로 아무리 영업비밀 및 기밀 비즈니스 정보를 보호해야 할 필요성을 충분히 고려한다 할지라도 그 경계가 모호하다. 한편 이 법은 엄격한 페널티를 규정하고 있다. 제5조에 명시된 금지된 AI 관행에 관한 조항을 준수하지 않은 경우의 최대 35,000,000유로 또는 기업일 경우 직전 회계연도 전 세계 연간 총 매출액의 최대 7% 중 더 높은 금액이 부과될 수 있다. 특히 GPAI에 대하여는 GPAI 모델 제공업체에 직전 회계연도 전 세계 총 매출액의 3% 또는 1,500만 유로 중 더 높은 금액을 초과하지 않는 범위에서 부과할 수 있다. 벌금은 수범자가 충분히 적응할 시간을 가지도록 이 법 관련 조항이 적용된 지 1년 후에 부과된다. 또한 AI 사무국은 본 법의 실효성 있는 시행을 위해 국제적 접근 방식을 고려하여 유럽연합 차원의 실천강령 작성을 장려하고 촉진한다.61 AI 사무국과 AI 위원회는 실천강령의 내용이 GPAI 모델 제공업체(시스템적 위험이 있는 GPAI 모델 포함)의 의무사항에 규정된 사항을 포함하되 반드시 이에 국한되지 않도록 정한다.

한편 장려한 규제의 대상인 “고위험 AI 시스템”은 대부분은 법집행, 교육·직업훈련 등 공공부문에 해당되며, 수도·가스·난방·전기 등 인허가 사업에 해당되는 중요 인프라라고 할 수 있다. 그러나 기계류, 장난감 등의 제품도 포함되므로 그 범위는 매우 폭넓게 규정되어 있다고 볼 수 있다. 구인 광고 게재, 입사 지원서 분석 및 필터링, 입사지원 후보자 평가에 사용하는 AI시스템, 성과와 행동을 모니터링 및 평가하는 데 사용하도록 고안된 AI 시스템 등은 민간에서도 널리 사용될 수 있는 서비스이나 “고위험 AI 시스템”으로 분류된 만큼 각별한 주의가 필요하다. 특히 AI 시스템이 자연인의 프로파일링을 수행하는 경우 해당 AI 시스템은 항상 고위험군으로 간주 되므로 관련 서비스 개발 시 특히 주의할 필요가 있다.

EU 인공지능법은 2021년 제안된 법안과 불과 3년 만에 상당 부분 내용의 변화를 겪었다. 현재 본격 시행 시기를 2∼3년 후인 2026년으로 본다면 그 사이의 급격한 변화에 대하여 이 법이 어떠한 방식으로 시행될지는 두고 볼 일이다.

바이든 행정명령 역시 다양한 찬반론이 존재한다. 잭 클락 앤트로픽 공동 창업자는 “AI 시스템 테스트 및 평가에 중점을 두는 것은 좋은 것 같다. 측정할 수 없는 것은 관리할 수 없다”라고 하였으나, “새로운 기업과 경쟁업체가 시장에 진입하는 것을 막고 미국 혁신에 대한 연방정부의 권한을 크게 확장하게 될 것”이라는 비판도 있다.62) 그러나 무엇보다도 행정명령의 한계상 정치적 상황을 예의 주시할 필요가 있다. 미국 행정명령은 법적 성질상 사전허용, 사후통제 방식이므로 의회의 결정을 주목할 필요가 있다. 특히, 올해 11월에는 미국 대통령 선거가 있는 만큼 공화당이 집권을 하게 되면 바이든 행정명령의 방향도 달라질 수 있다.63 무엇보다도 미국의 AI 관련 법률은 117대, 118대 의회에 걸쳐 다수 발의됐으나 여전히 통과한 AI 법안이 없다. 상·하의원 모두 발의한 알고리즘 책임법64)조차 118대 의회에 통과하지 못하다는 점은 그만큼 의회에서 AI에 대한 ‘규제’에 신중하다고 추론할 수 있다.

앞서 검토한 바와 같이 각국이 인공지능과 관련해 취하고 있는 규범은 아직 본격 시행된 바 없으며, 따라서 그 시행 효과도 불투명하다. 다만 이제 글로벌 인공지능 규범 선점의 움직임이 시작됐다는 것은 부인할 수 없다. 블레츨리 선언은 “구속력 있는 인공지능 규제에 대한 각 국가의 치열한 신경전” 혹은 “인공지능을 중심으로 한 새로운 디지털 질서에서 주도권을 다투는 주요국들의 전략 확인”이라 칭하는 것이 과언은 아니다.

우리는 이러할 글로벌 움직임에 촉각을 세우되, 우리 산업생태계와 실정에 부합하는 규범의 방향을 신중하게 모색해야 할 것이다. “AI기술, 산업 없는 규범은 뿌리 없는 나무”라는 혹자의 우려에 특히 공감하는 바이다.65

<참고문헌>

김경숙·홍건식. 바이든 행정부의 첫 인공지능(AI) 행정명령과 시사점. 이슈브리프 480호, 국가안보전략연구원.

윤정현·조은정, “EU ‘인공지능 규제법(AI Act)’ 통과의 의미와 시사점,” INSS 이슈브리프, 제527호, 2024.

European Commission (2024.4.19.), Proposal for a Regulation of the European Parliament and of the Councillaying down harmonised rules on artificial intelligence (Artificial IntelligenceAct) and amending certain Union legislative acts.

Executive Order No. 14110, “Securing the Information and Communications Technology and Services Supply Chain”, Oct 30, 2023, 88 Fed. Reg. 75191.

NIST, “Biden-Harris Administration Announces First-Ever Consortium Dedicated to AI Safety”, 「Office of Public Affairs」, 2024.

- European Commission, Proposal for a REGULATION OF THE EUROPEAN PARLIAMENT AND OF THE COUNCIL LAYING DOWN HARMONISED RULES ON ARTIFICIAL INTELLIGENCE (ARTIFICIAL INTELLIGENCE ACT) AND AMENDING CERTAIN UNION LEGISLATIVE ACTS), COM/2021/206final, Brussels, 21.4. 2021. [본문으로]

- 윤정현, 조은정, “EU ‘인공지능 규제법(AI Act)’ 통과의 의미와 시사점,” INSS 이슈브리프, 제527호, 2024년 3월 25일, 4쪽 [본문으로]

- Executive Order No. 14110, “Securing the Information and Communications Technology and Services Supply Chain”, Oct 30, 2023, 88 Fed. Reg. 75191. [본문으로]

- Talha Burki, “Crossing the frontier: the first global AI safety summit”, 「The Lancet Digital Health」, Elsevier Ltd, 2024, pp.91-92. [본문으로]

- 시행일정은 발효 6개월 뒤부터 금지 대상 AI 규정이 우선 시행되며, 12개월 이후부터는 범용 AI(GPAI)에 대한 규제가, 24-36개월 이후 고위험 AI규제가 시행된다. 따라서 전면 시행은 2026년 이후다. [본문으로]

- EU 인공지능법 제1조 제1항 [본문으로]

- EU 인공지능법 제2조 제1항 [본문으로]

- EU 인공지능법 제2조 제3항 및 제4항 [본문으로]

- EU 인공지능법 제2조 제5a항 [본문으로]

- EU 인공지능법 제2조 제5b항. [본문으로]

- EU 인공지능법 제2조 제5c항 [본문으로]

- EU 인공지능법 제2조 제5g항. [본문으로]

- EU 인공지능법 제5조 제1항(a [본문으로]

- EU 인공지능법 전문(16); EU 인공지능법 제5조 제1항(a [본문으로]

- EU 인공지능법 전문(16a); EU 인공지능법 제5조 제1항(ba [본문으로]

- EU 인공지능법 전문(17); EU 인공지능법 제5조 제1항(c [본문으로]

- EU 인공지능법 전문(18)(19) ; EU 인공지능법 제5조 제1항(d [본문으로]

- 부속서 IIa에 언급된 형사 범죄 목록은 ‘실시간’ 원격 생체 인식 시스템에 의존하는 것이 다른 범죄보다 더 관련성이 높을 수 있다는 점에서 일부 범죄가 실제로 더 관련성이 높을 수 있다는 점을 고려하여 이사회 기본 결정 2002/584/JHA9(유럽 체포영장 및 회원국 간 항복 절차에 관한 2002년 6월 13일의 이사회 기본 결정 2002/584/JHA(OJ L 190, 2002.7.18., 1면)에 나열된 32개의 형사범죄를 기반으로 한다. [본문으로]

- EU 인공지능법 제5조 제1항(da [본문으로]

-

– 해당제품으로 기계류, 장난감, 레저용 선박 및 개인용 선박, 리프트( 및 관련 부품), 폭발 가능성이 있는 대기에서 사용하기 위한 장비 및 보호 시스템, 무선 장비, 압력 장비, 케이블카, 개인 보호 장비, 기체 연료를 연소하는 기기, 의료기기, 체외 진단 의료기기

– 민간 항공, 이륜차 및 사륜차, 농업 및 임업용 차량, 해양 장비, 철도 시스템, 자동차 및 트레일러, 이러한 차량을 위한 시스템, 부품 및 별도의 기술, 무인항공기 등

[본문으로]

- EU 인공지능법 제6조 제1항 [본문으로]

- 1)국내법에 따라 허용되는 “생체인식”, 2) 디지털 인프라, 도로 교통, 수도, 가스, 난방 및 전기 등 중요 인프라, 3) 교육 및 직업 훈련, 4) 고용, 근로자 관리 및 자영업에 대한 접근성, 5)필수적인 사적 또는 공공 서비스와 그 혜택에 대한 접근과 향유, 6) 법 집행 기관(관련 법에 따라 사용이 허용되는 것을 전제로 함), 7) 이주, 망명 및 국경 통제 관리( 관련 법에 따라 사용이 허용되는 것을 전제로 함), 8) 사법 민주적 절차의 관리 등이다. [본문으로]

- EU 인공지능법 제9조 [본문으로]

- EU 인공지능법 제10조 [본문으로]

- EU 인공지능법 제11조 [본문으로]

- 1) 시스템에 대한 일반적인 설명과 2) AI 시스템의 구성 요소와 개발 프로세스에 대한 자세한 설명, 3) AI 시스템의 모니터링, 기능 및 제어에 대한 자세한 정보를 포함한다. 일례로 “시스템의 설계 사양, 즉 AI 시스템과 알고리즘의 일반적인 논리, 시스템을 사용하려는 사람 또는 그룹에 대한 근거와 가정을 포함한 주요 설계 선택 사항, 주요 분류 선택사항, 시스템이 최적화하도록 설계된 대상과 다양한 매개변수의 관련성, 시스템의 예상 출력 및 출력 품질에 대한 설명” 그리고 “시스템의 설계 사양, 즉 AI 시스템과 알고리즘의 일반적인 논리, 시스템을 사용하려는 사람 또는 그룹에 대한 근거와 가정을 포함한 주요 설계 선택 사항, 주요 분류 선택 사항, 시스템이 최적화하도록 설계된 대상과 다양한 매개변수의 관련성, 시스템의 예상 출력 및 출력 품질에 대한 설명” 등을 포함한다. [본문으로]

- EU 인공지능법 제12조 [본문으로]

- EU 인공지능법 제13조 [본문으로]

- EU 인공지능법 제14조 [본문으로]

- EU 인공지능법 제15조 [본문으로]

- EU 인공지능법 제17조, 제18조 [본문으로]

- EU 인공지능법 제20조 [본문으로]

- EU 인공지능법 제21조 [본문으로]

- EU 인공지능법 제29a조a : Fundamental rights impact assessment for high-risk AI systems [본문으로]

- 중요 인프라: 중요한 디지털 인프라, 도로 교통, 수도, 가스, 난방 및 전기 공급의 관리 및 운영에서 안전 구성 요소로 사용하기 위한 AI 시스템 [본문으로]

- 금융사기를 탐지할 목적으로 사용되는 AI 시스템을 제외하고 자연인의 신용도를 평가하거나 신용 점수를 설정하는 데 사용되는 AI 시스템 [본문으로]

- 생명보험 및 건강 보험의 경우 자연인과 관련된 위험 평가 및 가격 책정에 사용하기 위한 AI 시스템. [본문으로]

- EU 인공지능법 제44조 [본문으로]

- EU 인공지능법 제52조 : 특정 AI 시스템의 제공자 및 배포자에 대한 투명성 의무 [본문으로]

- EU 인공지능법 제3조 Definitions (44b) : ‘범용 AI 모델’이란 대규모 자체 감독을 사용하여 대량의 데이터로 학습된 경우를 포함하여 상당한 일반성을 나타내며 모델이 시장에 출시되는 방식에 관계없이 다양한 고유 작업을 유능하게 수행할 수 있고 다양한 다운스트림 시스템 또는 애플리케이션에 통합될 수 있는 AI 모델을 의미한다. 연구, 개발 및 프로토타이핑 활동을 위해 시장에 출시되기 전에 사용되는 AI 모델에는 적용되지 않는다. [본문으로]

- EU 인공지능법 제52a조 [본문으로]

- EU 인공지능법 제52a조 제1항. [본문으로]

- EU 인공지능법 제52a조 제2항. [본문으로]

- EU 인공지능법 제52b조 제1항 [본문으로]

- EU 인공지능법 제52b조 제2항 [본문으로]

- EU 인공지능법 제52b조 제3항 [본문으로]

- EU 인공지능법 제52c조 [본문으로]

- 모든 GPAI 모델 제공업체가 제공해야 하는 정보로는 “1) GPAI 모델에 대한 일반적인 설명, 2) 1)에 언급된 모델의 요소에 대한 자세한 설명과 다음을 포함한 개발 프로세스 관련 정보”를 기재하도록 하고 있으며, 시스템적 위험이 있는 GPAI 모델 제공업체가 제공해야 할 추가정보로 “사용 가능한 공개 평가 프로토콜 및 도구 또는 기타 평가 방법론에 근거하여 평가 결과를 포함한 평가 전략에 대한 자세한 설명”을 기재하도록 규정하고 있다. [본문으로]

- “GPAI 모델에 대한 일반적인 설명”과 “모델의 요소와 개발 프로세스에 대한 설명”으로 구분되어 기재하도록 되어있다. 후자의 경우(a) GPAI 모델을 AI 시스템에 통합하는 데 필요한 기술적 수단(예: 사용 지침, 인프라, 도구)(b) 양식(예: 텍스트, 이미지 등)과 입력 및 출력의 형식 및 최대 크기(예: 컨텍스트 창 길이 등)의 지정 (c) 학습, 테스트 및 검증에 사용된 데이터에 대한 정보(해당되는 경우, 데이터의 유형 및 출처, 큐레이션 방법론 포함) 등이다. [본문으로]

- EU 인공지능법 제52d조 [본문으로]

- 미국에서 역사적으로 행정명령 사례는 다수 존재한다. 프랭클린 루스벨트 대통령은 뉴딜 정책을 집행하기 위한 다수의 행정명령을 발하였으며, 케네디 대통령은 흑백 거주지역 분리 금지 명령, 존슨 대통령은 소수민족 우대 조치(affirmative action)를 위한 명령, 닉슨 대통령은 임금 및 물가 동결 명령, 조지 부시 대통령은 9/11 테러 이후 외국인을 체포, 구금, 재판할 수 있는 명령 등을 발한 바 있다. 다만 어떤 법률 문서에도 이러한 행정명령에 대하여 정의하고 있지 않다. 연방연구의회처(CRS: Congressional Research Service)는 ‘행정명령은 대통령이 정책을 수립하기 위한 지시를 내릴 수 있는 서면 문서이다. 미국 헌법은 행정명령에 대해 언급하고 있지 않으며 대통령에게 행정명령을 발령할 수 있는 일반적인 권한을 부여하는 법령도 없지만, 이러한 명령의 법적 효력은 다양한 고려 사항에 따라 다루어지더라도 대통령 권한의 고유한 측면으로 받아들여지고 있다’고 언급하고 있다( Executive Orders: An Introduction,March 29,2021, Congressional Research Service, p2). 하지만 이러한 행정명령은 의회의 반대 입법에 의해 또는 의회의 예산 권한에 의해 무력화시킬 수 있다. 또한 현직 대통령은 자신이나 전임 대통령의 행정명령을 새 행정명령을 통해 철폐하거나 수정할 수 있다. 일례로 2015년 오바마 대통령은 ‘연방 정부의 에너지 소비를 줄이는’ 내용의 행정명령을 철폐하고 기후 변화에 대한 연방 정부의 기여를 줄이기 위한 더 포괄적인 내용의 행정명령으로 대체한 바 있다. [본문으로]

- 김경숙,홍건식. 바이든 행정부의 첫 인공지능(AI) 행정명령과 시사점. 이슈브리프 480호, 국가안보전략연구원. 1쪽. [본문으로]

- Transformer 모델은 AI 연구에서 연결 주의 AI에 해당하는 것으로, 인간 두뇌의 구조와 생물학적 뉴런 네트워크를 모방하여 기계가 학습하고 추론하도록 한다. [본문으로]

- Anton Korinek and Jai Vipra, “Market Concentration Implications of Foundation Models: The Invisible Hand of ChatGPT,” 79th Economic Policy Panel Meeting, 4-5 April 2024, p. 9. [본문으로]

- The Economist, “Just how rich are businesses getting in the AI gold rush? Nvidia and Microsoft are not the only winners,” 2024, https://www.economist.com/business/2024/03/17/just-how-rich-are-businesses-getting-in-the-ai-gold-rush (2024.6.11.최종확인 [본문으로]

- Ben Cottier, “Trends in the Dollar Training Cost of Machine Learning Systems”. Published online at epochai.org, 2023, https://epochai.org/blog/trends-in-the-dollar-training-cost-of-machine-learning-systems (2024.6.11.최종확인 [본문으로]

- https://www.statista.com/statistics/1458132/ai-tool-market-share/ (2024년 6월 6일 검색 [본문으로]

- ‘AI 안전 정상 회의’ 개최 4개월 전 출범한 FMF는 성능 벤치마크, 고위험 역량 평가 등에 따라 최소 12개월 이상 널리 배포된 다른 모든 모델보다 뛰어난 성능을 보여야 프론티어 AI로 인정받을 수 있다. 즉, FMF의 회원으로 참여하기 위해서는 FMF의 회원사가 아닌 다른 모든 AI 시스템에 비해 뛰어난 성능을 가진 AI를 개발해야 한다. 그 기준에 부합하는 회사가 FMF 창립 당시의 4개 회사였다. 즉, 설립 당시 성능 평가 1위에서 4위에 해당하는 회사가 모여 FMF를 창립했다고 할 수 있다. 지난 2023년 5월에는 아마존과 메타가 FMF에 합류했다 [본문으로]

- NIST, “Biden-Harris Administration Announces First-Ever Consortium Dedicated to AI Safety”, 「Office of Public Affairs」, 2024, https://www.nist.gov/news-events/news/2024/02/biden-harris-administration-announces-first-ever-consortium-dedicated-ai (2024.6.11.최종 확인 [본문으로]

- Dieuwertje Luitse and Wiebke Denkena, “The Great Transformer: Examining the Role of Large Language Models in the Political Economy of AI,” Big Data & Society, July–December 2021, pp. 8. [본문으로]

- EU 인공지능법 제52e조 [본문으로]

- AI타임스(2023.10.31), “바이든, 최초 AI 행정명령 발표…”첨단 AI 위험, 정부에 보고할 것” (https://www.aitimes.com/news/articleView.html?idxno=154782 2024.6.10최종확인 [본문으로]

- 트럼프 전 대통령은 내년 11월 대선에서 승리하면 취임 첫날 바이든 행정부의 인공지능 관련 행정명령을 폐지할 것이라고 밝힌바 있다(ABB Anything But Buddin). [본문으로]

- 미국 상·하원에서 각각 ‘인공지능 책임법안(Algorithmic Accountability Act of 2022)’을 발의(‘22.2.3. [본문으로]

- 이숙연 고법판사는 2024년 4월 29일 한국지능정보사회진흥원이 개최한 지능정보법포럼에서 “AI기술, 산업 없는 규범은 뿌리 없는 나무”라고 언급하였다. [본문으로]

이전 글

이전 글  다음 글

다음 글  국가사이버안보법 제정 논란의 시시비비

국가사이버안보법 제정 논란의 시시비비  미연방대법원, 허위 정보 대응을 위한 정부와 미디어 플랫폼 간 교류 수긍

미연방대법원, 허위 정보 대응을 위한 정부와 미디어 플랫폼 간 교류 수긍  의료광고 사전심의제도 자율규제 도입의 의미와 전망

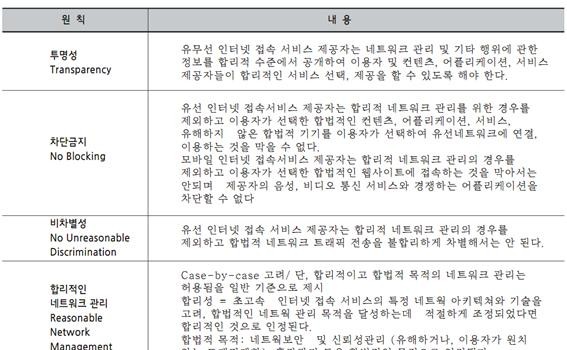

의료광고 사전심의제도 자율규제 도입의 의미와 전망  FCC 오픈 인터넷 규칙 승인 내용 및 향후 전망

FCC 오픈 인터넷 규칙 승인 내용 및 향후 전망  EU GDPR 주요 내용의 검토

EU GDPR 주요 내용의 검토  4차 산업혁명 관련 국내외 정책 및 입법 동향

4차 산업혁명 관련 국내외 정책 및 입법 동향  방통위 설치법 개정과 이용자 권리 보호

방통위 설치법 개정과 이용자 권리 보호  전자금융거래법 개정의 의미와 주요 쟁점

전자금융거래법 개정의 의미와 주요 쟁점